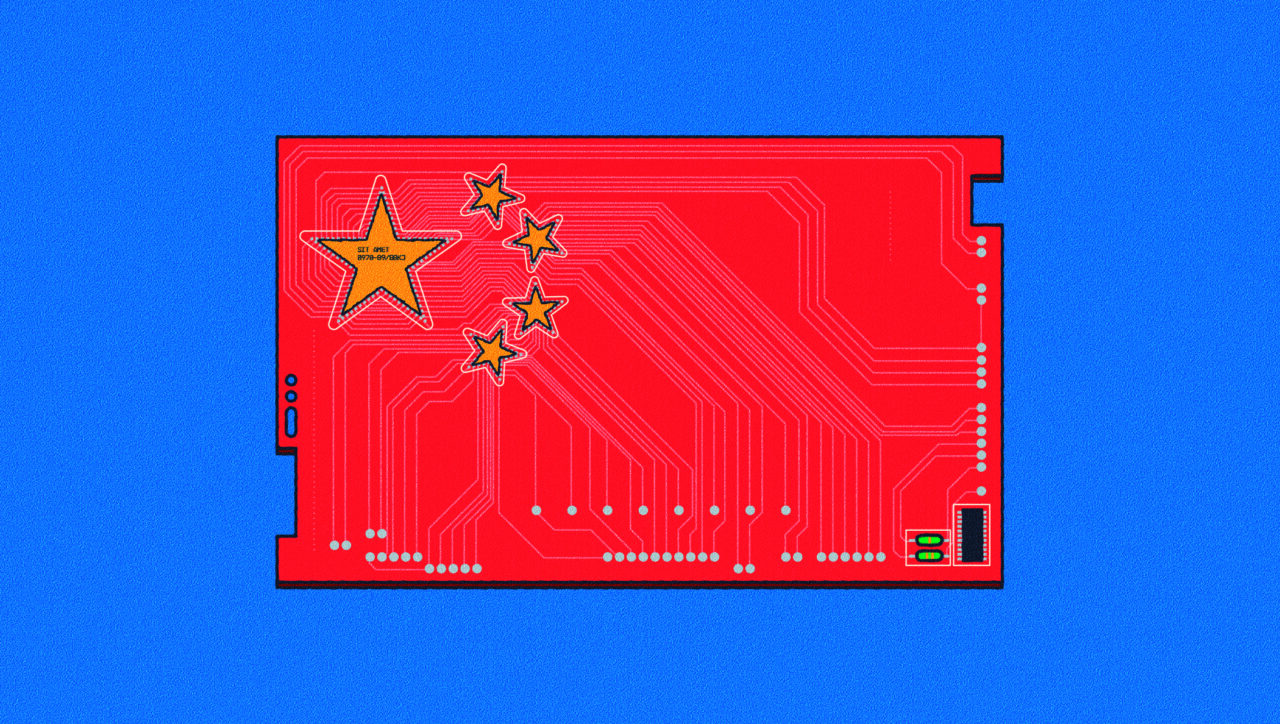

La black list made in China: lista delle fonti dannose per addestrare l’Intelligenza Artificiale

La Cina propone una lista nera di dati di addestramento per i modelli generativi di IA

La Cina ha pubblicato una proposta di requisiti di sicurezza per le aziende che offrono servizi basati sull’intelligenza artificiale generativa, compresa una lista nera di fonti che non possono essere utilizzate per addestrare i modelli di IA. L’intelligenza artificiale generativa, resa popolare dal successo della chatbot ChatGPT di OpenAI, impara a compiere azioni a partire da dati passati e crea nuovi contenuti come testi o immagini sulla base di tale addestramento.

Se più del 5% di informazioni viene considerata dannosa andrà nella black list

I requisiti sono stati pubblicati mercoledì dal Comitato nazionale per la standardizzazione della sicurezza informatica, che comprende funzionari della Cyberspace Administration of China (CAC), del Ministero dell’Industria e dell’Information Technology e della polizia. Il comitato propone di effettuare una valutazione della sicurezza di ogni contenuto utilizzato per addestrare i modelli di IA generativa rivolti al pubblico; quelli che contengono “più del 5% di informazioni illegali e dannose” saranno inseriti nella lista nera.

Nel dettaglio

Tali informazioni includono “incitamento al terrorismo” o alla violenza, oltre a ” chi rovescia il sistema socialista”, il “danneggiamento dell’immagine del Paese” e “minare l’unità nazionale e la stabilità sociale”. La bozza di regole stabilisce anche che le informazioni censurate su Internet in Cina non dovrebbero essere utilizzate per addestrare i modelli. La pubblicazione della black list arriva poco più di un mese dopo che le autorità di regolamentazione hanno permesso a diverse aziende tecnologiche cinesi, tra cui il gigante dei motori di ricerca Baidu, di lanciare i loro chatbot generativi guidati dall’IA al pubblico.