Google, le 5 regole per una IA sicura

Dopo le leggi di Asimov sulla robotica, è Google a dettare le sue regole per la realizzazione sicura di una inteligenza artificiale.

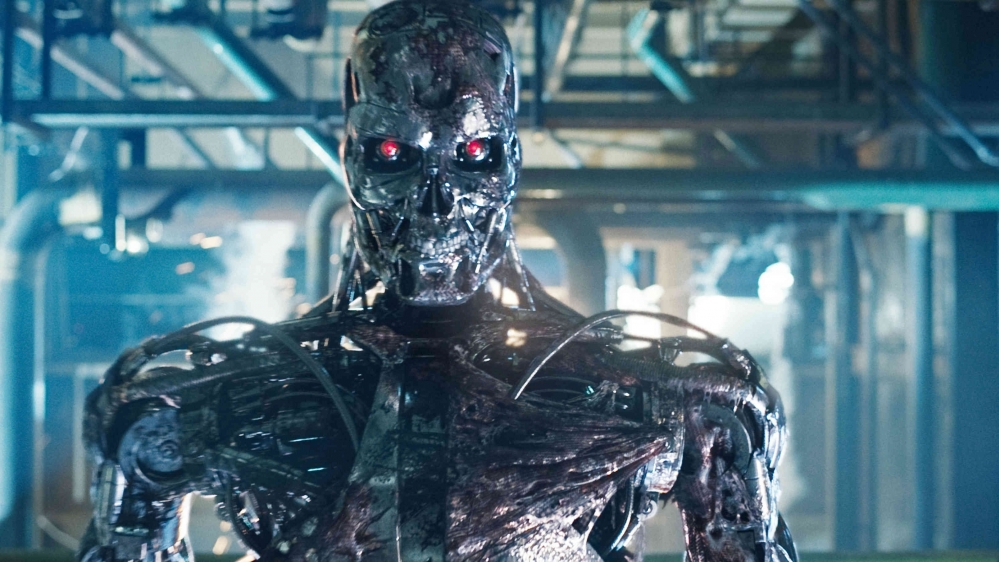

Tutti vogliono creare una perfetta intelligenza artificiale, ma nessuno vuole rischiare di ricreare Skynet del film Terminator. Così la divisione Google Research rende pubblico un comunicato con le sue 5 regole per lo sviluppo di un’IA sicura.

Il titolo del documento prende il nome di Concrete Problems in AI Safety. Vediamo i punti principali:

- Evitare effetti collaterali negativi: bisogna asscurarsi che l’IA non disturbi l’ambiente circostante, nello svolgimento delle sue attività.

- Evitare il “Reward Hacking”: l’intelligenza artificiale non deve imbrogliare, dando a credere di aver compiuto la sua attività in modo corretto, quando invece non è così.

- Supervisione scalabile: l’intelligenza artificiale può ricevere feedback dall’uomo per migliorarsi, ma a un certo punto deve essere in grado di cavarsela da sola.

- Esplorazione sicura: l’IA può esplorare per compiere le sue attività, ma non deve danneggiare se stessa o l’ambiente circostante

- Affidabilità al cambiamento: l’intelligenza artificiale deve essere in grado di svolgere le sue mansioni in modo efficace anche in un ambiente diverso da quello in cui ha imparato ad agire inizialmente.

Le macchine emersero dalle ceneri dell’incendio nucleare. La loro guerra per sterminare il genere umano aveva infuriato per anni e anni. Ma la battaglia finale non si sarebbe combattuta nel futuro: sarebbe stata combattuta qui, nel nostro presente… Oggi.

da Terminator

- Bringing Precision to the AI Safety Discussion (research.google.com)

- Concrete Problems in AI Safety (documento tecnico sulla ricerca)