L’Errore della Birra Media

Per molti l’errore della birra media è la sua esistenza: ma fu grazie alla birra che nacque la statistica industriale, anche se adesso alcune sue assunzioni sono in discussione.

Questo articolo viene pubblicato grazie alla revisione di Abibobe | Fuffaiter, a cui vanno tutti i ringraziamenti (e le responsabilità) :)

A fine ‘800 la Guinness era già la più nota marca di birra al mondo e in piena espansione, con 300 milioni di litri prodotti nel 1887 e raddoppiati allo scoppio della Grande Guerra.

Doveva quindi risolvere problemi di vario genere: la chimica per il gusto, l’economia per l’acquisto di materie prime a maggior quantità e minor prezzo, la logistica per la spedizione e così via, il tutto mantenendo la qualità finale del prodotto.

Aveva perciò un centro ricerche molto avanzato, che insolitamente includeva un reparto di statistica, all’epoca usata in campo accademico per studi biometrici.

Il problema

Uno dei problemi più pressanti era selezionare le infiorescenze di luppolo (hops) per dare aroma al prodotto: ne servivano oltre 2.200 tonnellate scelte per “apparenza e fragranza”, parametri non quantitativi che non permettevano di ottimizzare il processo.

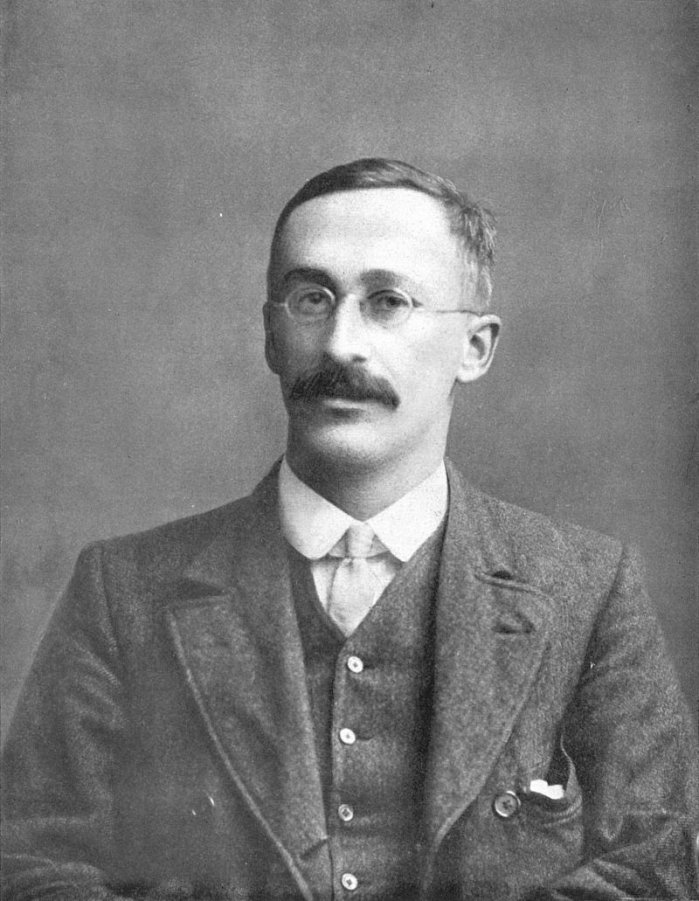

Nel 1899 il centro studi assunse come birraio sperimentale il 23enne William Sealy Gosset: figlio di un colonnello dei Royal Engineers, non aveva potuto seguire la carriera militare del padre per problemi di vista ma aveva studiato matematica a Winchester e scienze naturali ad Oxford.

Nel 1899 il centro studi assunse come birraio sperimentale il 23enne William Sealy Gosset: figlio di un colonnello dei Royal Engineers, non aveva potuto seguire la carriera militare del padre per problemi di vista ma aveva studiato matematica a Winchester e scienze naturali ad Oxford.

All’epoca non c’era un metodo per fare inferenze, ovvero ottenere soluzioni probabili da un numero limitato di campioni: se c’era già una ipotesi di soluzione poche misure potevano bastare, ma non si riusciva a misurare l’accuratezza di soluzioni non note a priori.

Nel mondo accademico si usava la distribuzione normale per valutare le soluzioni più probabili, ma si dovevano avere molti campioni da esaminare, dove il “molti” significava almeno 30. Nei processi industriali questo poteva essere un costo troppo alto: persino la Guinness, una Silicon Valley della birra, avrebbe dovuto produrre 30 lotti appositi pronti per essere buttati e nel frattempo continuare la produzione normale.

Tecnicamente parlando Gosset doveva calcolare di quanto si allarga il margine di errore al ridursi del numero di campioni disponibili. Il problema specifico divenne: quanto estratto di malto occorre campionare per essere ragionevolmente certi che il suo grado di zucchero reale sia vicino al valore desiderato (o atteso) di 133, con un errore di 0,5 gradi più o meno?

Grazie a @Daniele per la precisazione sullo zucchero invece della saccarina.

Partì da un’estrazione precedente di migliaia di campioni, in cui il grado di zucchero era praticamente certo: vide che prendendo due campioni a caso c’era l’80% di probabilità di finire entro l’errore previsto. Tre campioni davano una probabilità dell’87% di finire tra 132,5 e 133,5, mentre con quattro campioni la probabilità era del 92%.

L’azienda era quindi in grado di verificare che i lotti di birra prodotti fossero come li voleva prendendone quattro campioni a caso ciascuno e misurandone il contenuto zuccherino.

La funzione

Gosset però voleva una funzione matematica più precisa di quanto l’errore si riducesse all’aumentare del numero di campioni: chiese perciò un sabbatico per lavorare nel laboratorio di Karl Pearson all’University College di Londra.

Pearson all’epoca era un matematico molto noto nel Regno Unito, e il suo laboratorio divenne nel 1911 il primo dipartimento di statistica universitario al mondo.

All’epoca gli studi statistici servivano soprattutto per demografia e biometria: il laboratorio di Pearson era inizialmente dedicato all’eugenetica.

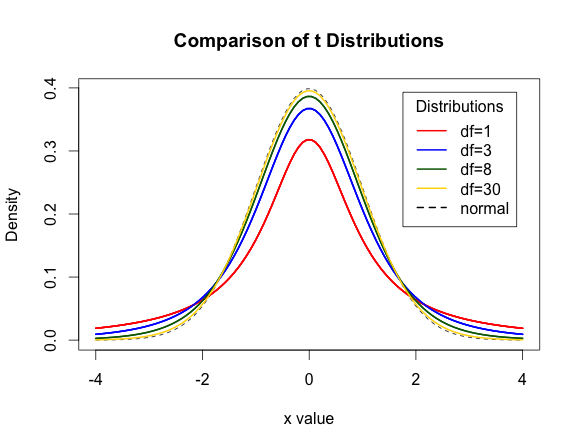

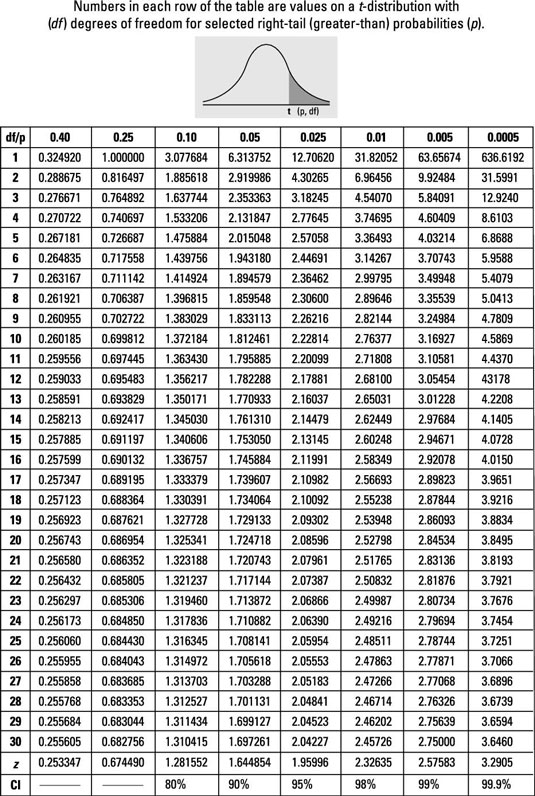

In un anno Gosset ottenne una tabella che legava la distanza dalla misura voluta al numero di campioni esaminati, chiamata distribuzione t.

La tabella era completamente generale e permetteva di valutare l’errore per un parametro misurato con osservazioni statisticamente indipendenti su una popolazione omogenea con una distribuzione normale standard.

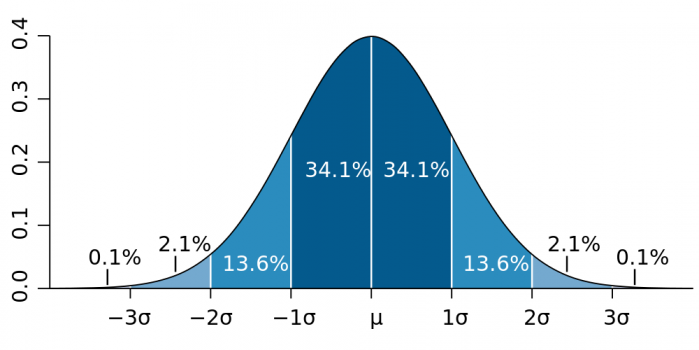

La distribuzione normale è una distribuzione continua di probabilità usata quando non si conosce la distribuzione reale di variabili aleatorie: grazie al teorema centrale del limite sappiamo che le medie di estrazioni indipendenti tendono ad una distribuzione normale.

Le variabili sono indipendenti quando sono estratte in maniera completamente casuale e ripetibile: sarebbero dipendenti se, ad esempio come nella tombola, un valore estratto ora non potesse essere più estratto dopo.

La distribuzione normale standard è un caso particolare di distribuzione normale in cui i parametri che ne descrivono la curva, la media μ (mu) e la deviazione standard σ (sigma) sono rispettivamente 0 e 1 permettendo calcoli semplificati.

La curva viene chiamata anche “campana” o “gaussiana”, a volte impropriamente perché ci sono molte altre distribuzioni con forma “a campana” e la curva di Gauss non ha sempre un integrale pari a 1 come ci si aspetta da una distribuzione di probabilità.

Gosset aveva scoperto che estraendo sempre più campioni da un insieme che si avvicinava a 30 elementi, il valore medio osservato si avvicina sempre di più alla media μ della distribuzione normale, e soprattutto di quanto.

Nelle immagini, df sta per degrees of freedom, il numero di campioni analizzati.

Era una scoperta eccezionale che l’azienda non voleva rendere pubblica per non far sapere ai concorrenti come verificare la bontà della loro birra. Come compromesso fu pubblicata sotto pseudonimo: nel 1908 uscì quindi The probable error of a mean, scritto da un certo Student. All’epoca l’articolo fu per lo più ignorato: erano in fondo solo 24 pagine, per la maggior parte occupate dalla simulazione Monte Carlo che ne dimostrava il metodo.

L’estensione

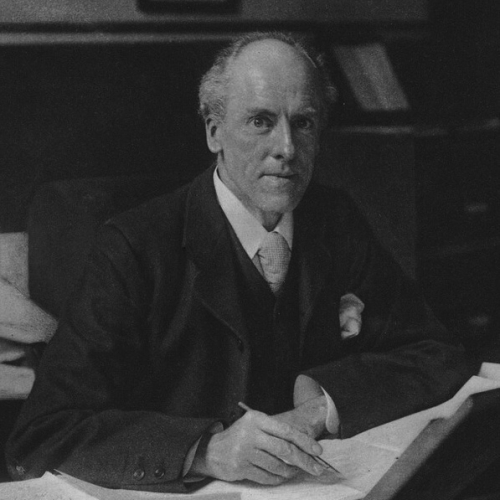

Il giovane matematico Ronald Aylmer Fisher notò subito l’articolo di Gosset e lo usò come base per i suoi lavori successivi, con cui si guadagnò la fama di padre della statistica moderna.

Il giovane matematico Ronald Aylmer Fisher notò subito l’articolo di Gosset e lo usò come base per i suoi lavori successivi, con cui si guadagnò la fama di padre della statistica moderna.

Nel 1925 estese quei concetti nelle 320 pagine del suo Statistical Methods for Research Workers, ancora oggi usato e citato nei corsi di statistica: fu l’inizio della diffusione di quella scienza fuori dal mondo dell’accademia.

Purtroppo però c’erano delle differenze: Fisher usava la scoperta di Gosset per l’analisi della varianza in demografia, introducendo il concetto di rilevanza stastistica. Se le differenze dai valori attesi restavano nell’intervallo prefissato almeno il 95% delle volte in campioni presi a caso, indipendentemente dal processo osservato, li definì come statisticamente rilevanti.

Un esempio pratico: per valutare l’efficacia di un nuovo metodo di insegnamento B rispetto ad uno vecchio A, si estraggono a caso i risultati di 100 studenti istruiti con il metodo B e altrettanti dello A, e si calcolano le medie. Se la differenza tra la media del campione per il metodo A e quella per il metodo B supera il test eseguito con un intervallo del 95%, Fisher afferma che la differenza è statisticamente rilevante, cioè c’è al massimo il 5% di probabilità che questo sia dovuto al caso

Il limite del 5% è arbitrario, e genera vari dubbi: se i 100 campioni vengono dalla stessa scuola è un conto, ma se sono scelti su tutto il territorio nazionale? Poi è possibile che lo stesso limite vada bene anche in campi diversi, esempio per processi medici?

Quanto segue è un’altra precisazione dovuta a @Stewewino, già ringraziato.

Il problema non è tanto scegliere la soglia del 5% per la rilevanza statistica, quanto usarlo per fare differenze o stime di valori medi.

La crisi

La diffusione della soluzione 5% (cit.) fu tale che praticamente tutti gli studi statistici successivi ne sono stati influenzati: dal libro di Fisher è passato quasi un secolo e le sue teorie sono state usate praticamente in ogni campo.

Recentemente però alcuni studi sono stati replicati, ottenendo risultati diversi dall’originale: articoli sulla rivista Science hanno mostrato che più della metà degli studi psicologici e circa il 40% degli studi economici hanno fallito la riproduzione. Ci possono essere altri fattori, ma è evidente che la soglia non è adatta a tutti i campi: in medicina ad esempio occorre essere ancora più precisi.

Una proposta è di usare la soglia del 99,5% come “significativa” e lasciare al 95% il concetto di “suggestivo” per spingere verso esami con più campioni partendo dagli esperimenti già effettuati. Ovviamente questo va di pari passo con l’aumento di precisione dei calcoli: la tabella di Gosset aveva 5 cifre significative, oggi se ne possono considerare ben di più.

Il 99,5% è vicino al valore di tre sigma, ovvero tre volte la deviazione standard che in una distribuzione normale comprende il 99,7% dei casi: nell’esempio degli studenti la nuova soglia costringerebbe al massimo 5 di loro a non mostrare miglioramento selezionandoli tra 1.000 invece di 100.

Gosset ottenne comunque un risultato storico: migliorare il controllo della qualità di un prodotto industriale, introducendovi la statistica e Fisher lo generalizzò e diffuse per tutti i processi. Non è poco: un artigiano può controllare praticamente tutti i propri prodotti, ma la quantità di merci che esce da un’industria lo rende impossibile. Non stupisce che proprio un birrificio abbia ottenuto questo risultato: a differenza dei vinificatori, che distinguono per annate e produzione, i birrai cercano l’omogeneità nel tempo.

Nel campo del controllo di qualità sono nati metodi

Nel campo del controllo di qualità sono nati metodi

In seguito Gosset si interessò alla produzione di varietà di orzo robuste, ovvero che portassero un raccolto consistente nonostante cambiamenti nel terreno o nel clima, e nel 1935 si trasferì a Londra come capo birraio del nuovo stabilimento Guinness. Morì per un attacco cardiaco due anni dopo, a 61 anni.

- Standard Normal Distribution (wikipedia.org)

- Ipotesi nulla (wikipedia.org)

- Teorema di Bayes (wikipedia.it)

- Why most published research findings are false (plos.org)

- The Guinness brewer who revolutionized statistics (priceonomics.com)

- An error made in 1925 led to a crisis in modern science (qz.com)